Die internationale wissenschaftliche Evaluationskampagne TRECVID ist eine etabilierte Serie von Workshops, die sich auf die inhaltsbasierte Informationsgewinnung und Auswertung und digitaler Videos konzentriert. Jedes Jahr stellen sich Teilnehmer einer neuen realitätsnahen Aufgabe, die Forscher diverser internationaler Institute in einer Art Wettbewerb lösen. Die TRECVID-erfahrenen Forscher der Juniorprofessur Media Computing und der Professur Medieninformatik der Technischen Universität Chemnitz nahmen gemeinsam mit Prof. Dr. Dr. Gisela Susanne Bahr vom Florida Institute of Technology (FIT) zum zweiten Mal teil und waren dieses Jahr auch im Bereich der “Deep Learning Strategies” aktiv.

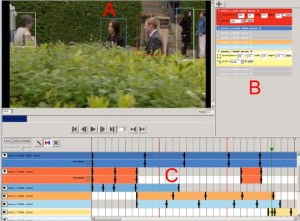

Zudem wurden neue Methoden bzw. deren Verknüpfungen im Task Instance Search angewendet, um die geforderten Bildinhalte in vier Durchgängen, davon ein interaktiver und drei automatische, korrekt zu erkennen. So wurden die Methoden CNN (Convolutional Neural Network), die eine Art künstliches neurales Netzwerk erstellen, bei dem die “Neuronen” auf sich überlappende Bereiche reagieren, und SIFT (Scale Invariant Feature Transform), bei dem die Merkmalsbeschreibungen invariant gegenüber z.B. Rotation, Skalierung, Beleuchtungsvariation etc. sind, mit einem vorangestellten Sequence Clustering (SC) kombiniert. Die Forscher stellten fest, dass die Methoden CNN und SIFT in mehr als der Hälfte der Fälle der geforderten Suchanfragen erfolgreich waren, wobei SIFT besonders gut bei strukturierten Objekten mit scharfen Kanten funktionierte. Zusätzlich erzielte das Sequence Clustering (SC) als Vorverarbeitungsprozess eine merkliche Verbesserung der Detektionsergebnisse, sodass die Forscher insgesamt mehrere verschiedene Potentiale zur Optimierung der Objekterkennung aufdeckten.

Die Ergebnisse wurden vom 16.–18. November 2015 beim National Institute of Standards and Technology, Maryland, USA von Juniorprofessor Dr. Marc Ritter präsentiert.

Publikation: Ritter, Marc; Rickert, Markus; Juturu Chenchu, Lokesh; Kahl, Stefan; Herms, Robert; Hussein, Hussein; Heinzig, Manuel, Manthey, Robert; Richter, Daniel; Bahr, Gisela Susanne & Eibl, Maximilian: Technische Universität Chemnitz at TRECVID Instance Search 2015. In: TRECVID Workshop, 16.–18.11.2015, Gaithersburg, Maryland, USA, 12 S. [Link@RG][Link@NIST]

![Measured color gamut of the Sanyo PDG-DWL 2500 projector with 64³ samples in the camera’s native color space [Quelle: Marcel Heinz; Guido Brunnett: Dense Sampling of 3D Color Transfer Functions Using HDR Photography]](http://medien.informatik.tu-chemnitz.de/localizeit/files/2015/07/farbverteilung_Marcel_Paper-300x274.jpg)