Auf Basis der Vorarbeiten zur Klassifikation von Vogelgesängen basierend auf neuronalen Faltungsnetzen (CNNs — Convolutional Neural Networks) gelang es uns in einem eigens dafür aufgebauten Audio-Datensatz einen Algorithmus zu entwickeln, der es erlaubt über 94 Klassen aus dem Bereich assistiertes Leben (AAL) automatisiert zu erkennen. Dazu gehören die Kategorien Musik, Tiere, menschliche Geräusche und heimische/Innenraumgeräusche. Die Güte der Klassifikation ist mit über 82% Accuracy vergleichbar mit den Spitzenwerten anderer Benchmarks aus dem Bereich Geräusch/Audioklassifikation. Die Ergebnisse wurden erfolgreich bei Top-Level A‑Konferenz ACM Multimedia eingereicht und werden dort in diesem Herbst in Nizza im Rahmen eines Demonstrators vorgestellt [1]. Das Demo-Video kann unter https://youtu.be/PpiL89t9_kY eingesehen werden.

Am 05. September trifft sich die InnoProfleTransfer-Intitative zum letzten Mal mit Stiftern, beteiligten Wissenschaftlern und Gästen in Chemnitz. Veranstaltungsdetails finden Sie hier: https://www.tu-chemnitz.de/informatik/mc/events_current.php

Es wird Übersichtsvorträge mit Highlights aus fünf Jahren Forschung zu den fünf Schwerpunkt-Themengebieten von LocalizeIT geben. Wir zeigen wie Fragestellungen der Klassifikation und Lokalisation von industriellen Prozessen, Objekten und Personen im Raum gelöst werden mit klassischer Bild- und Audioverarbeitung aber auch mit modernen Methoden aus dem Bereich künstlicher Intelligenz. Hier wurden vor allem mit sog. (tiefen) neuronalen Faltungsnetzen (CNNs — Convolutional Neural Networks) Erfolge erzielt, z.B. bei der Erkennung von Vogelstimmen [1] und Ambient-assisted-living relevanten Geräuschen [2], aber auch im Bereich der automatischen CNN-basierten Klassifikation von laserbasierten Schnittprozessen von Halbleiter-Wafern [3].

Die Vorträge werden weiterhin Einblicke geben in den Aufbau moderner Cluster- und GPU-Rechentechnik mit technischen Lösungen zum verteilten Rechnen, zum Massendatenhandling, sowie den Aufbau und Einsatz eines modernen Audio-Video-Labors.

Vogelgesangserkennung basierend auf neuronalen Netzen — das gibt es jetzt auch als Anwendung für Android-Geräte im Android App Store. Erkannt werden die 500 häufigsten Vogelarten aus Nord Amerika und Deutschland. Die App wurde inzwischen mehr als 100.000mal heruntergeladen und hat dabei eine über 4 Sterne Bewertung erzielt. Den wissenschaftlichen Hintergrund finden Sie in den Publikation von Stefan Kahl in der Rubrik Publikationen oder in der Localize-IT Projekt-Literaturverwaltung Zotero. Die Verarbeitung erfolgt teilweise auf unserer im Projekt beschafften GPU-Workstation. Diese App ist eine Zusammenarbeit des Cornell Lab of Ornithology und der Technischen Universität Chemnitz. Ein weiterführender Artikel findet sich hier.

Die Mitarbeiter der Initiative organsieren zwei Workshops Anfang 2019, um Ihre Forschung zu präsentieren, aber auch um Gäste aus ähnlichen Forschungsgebieten zum Diskurs einzuladen. Als Schwerpunkte beider Veranstaltungen werden maschinelle Lernverfahren insbesondere Deep Learning Methoden im Vordergrund stehen und das natürlich im Anwendungsfeld der Lokalisierung von und in audiovisuellen Medien. Das umfasst Themengebiet wie Objekt- und Personenerkennung und Verhaltensanalyse im Raum, basierend auf Audio- und (Multisensor-) Videoaufnahmen.

Zunächst beginnen wir mit einem Doktoranden-Workshop vom 05.–07.02.2019 der Medieninformatiker der TU Chemnitz und Hochschule Mittweida, das im Tagungszentrum der IBS gGmbH in Laubusch stattfinden wird. Weitere Details finden sich hier.

Im März 2019 findet dann am Wochenende vom 16./17.03. unser nationaler wissenschaftlicher LocalizeIT-Workshop im Rahmen der Chemnitzer Linux-Tage statt. Besonders gefragt sind Beiträge, die natürliche und sog. künstliche Intelligenz gegenüberstellen oder kombinieren. Weiterführende Informationen finden sich auf unseren Stiftungsjuniorprofessurwebseite.

Aktuell sind im Projekt Stellen als wissenschaftliche Mitarbeiter zu besetzen:

https://www.tu-chemnitz.de/verwaltung/personal/stellen/257080_14_Si.php

https://www.tu-chemnitz.de/verwaltung/personal/stellen/257080_13_Si.php

Weiterhin sind in vergleichbaren Themen Stellen als wissenschaftliche Hilfkraft verfügbar.

Beim international renommierten wissenschaftlichen Wettbewerb ImageCLEF bestand die Herausforderung in der Sektion LifeClef in Jahr 2017 unter anderem in der Klassifikation von 1500 Vogelarten anhand ihres Gesangs in über 12.000 Audio-Aufnahmen (BirdCLEF 2017). Unter den ca. 100 Anmeldungen wurden schlussendlich von fünf internationalen Forschungsgruppen Ergebnisse eingereicht. ESF-Promotionsstudent Stefan Kahl von der Stiftungsjuniorprofessur Media Computing an der Fakultät für Informatik der TU Chemnitz erarbeitete in Kooperation mit Prof. Dr. Holger Klinck von der Cornell University (Cornell Lab of Ornithology, CLO) und Prof. Ritter von der Hochschule Mittweida (FB Medieninformatik) ein Konzept, das die Audiosignale von mehr als 36.000 Trainings-Samples in Bilder konvertiert um damit ein künstliches neuronales Netz zu trainieren, welches möglichst gut auf Vogelgesang adaptiert. Mit diesem Ansatz konnte eine Genauigkeit von fast 70% erreicht werden, was den 2. Platz hauchdünn hinter der Spitzenpositionen im Wettbewerb bedeutet. Die Ergebnisse wurden auf der ImageCLEF Konferenz in Dublin mit einem entsprechenden wissenschaftlichen Beitrag präsentiert.

In den folgenden Monaten soll gemeinsam mit dem CLO ein mobiles Monitoring-System entstehen, das die Erkennung von 650 Vogelarten der USA in Echtzeit ermöglicht. Ziel ist die flächendeckende Überwachung von Migration und Bestand zur Erhaltung der Biodiversität gefährdeter Regionen. Ein erster Prototyp ist bereits jetzt auf einem Raspberry Pi lauffähig und soll im Mai 2018 mit Beginn der Brutzeit im Nord-Osten der USA zum Einsatz kommen. Der aktuelle Stand ist unter der Live Demo und Android App ist auf der Webseite des Cornell Lab of Ornithology zu sehen: https://birdnet.cornell.edu/

Radiobeitrag im Deutschlandradio: http://ondemand-mp3.dradio.de/file/dradio/2018/04/11/birdnet_mit_kuenstlicher_intelligenz_vogelarten_dlf_20180411_1645_0f30779c.mp3

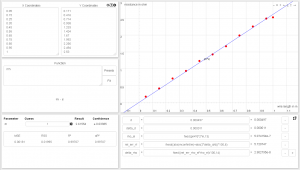

Screenshot der grafischen Nutzeroberfläche der Curvefit-Webanwendung im Kontext eines physikalischen Praktikumsversuchs

Bei der 6. Auflage der ISCET, welche dieses Jahr im Informatik-Begegnungszentrum Laubusch stattfand, wurde von den mehr als 30 Summer School-Teilnehmern der Beitrag “A web-based application for data visualisation and non-linear regression analysis including error calculation for laboratory classes in natural and life sciences” auf den 1. Platz gewählt. Dabei wurde sowohl Qualität des Vortrags als auch der schriftlichen Publikation im Tagungsband bewertet. Bei der ISCET Summer School treffen sich junge Forscher der TU Chemnitz und internationaler Universitäten aus Mongolei, Litauen, Russland, China und Pakistan zum wissenschaftlichen, aber auch kulturellen Austausch. Teil des Konzepts ist es Studierende bereits frühzeitig heranzuführen ihre Forschung in einer schriftlichen Arbeit für den ISCET-Tagungsband zu schreiben und diese dann zur Summer School zu präsentieren und Anknüpfungspunkte für Kooperationsprojekte suchen.

Ein Schwerpunkt besteht in sog. Bildungstechnologien. Die von Titus Keller im Rahmen seines Forschungspraktikums entstandene Webbrowseranwendung, die unter curvefit.tu-chemnitz.de erreichbar ist, wurde dabei in den Kontext der Durchführung physikalischer Praktikumsversuche gestellt. Dort könnten experimentell ermittelte Daten in Zukunft direkt digital erfasst, gespeichert, vorverarbeitet, graphisch visualisert und mittels Regressionsanalyse ausgewertet und per URL-Export als Gesamtprojekt geteilt werden. Das erlaubt dem Betreuer in bei der Bewertung des zu erstellenden Protokolls bessere Nachvollziehbarkeit, da jeder Berechnungsschritt transparent dokumentiert ist. Auch Größtfehlerabschätzung inkl. Fehlerfortpflanzung sind innerhalb der graphischen Oberfläche abbildbar. Perspektivisch lassen sich über den einfachen Weblink-basierten Export versuchsspezifische Muster-Projekte in einer Datenbank hinterlegen. Damit wird die Webanwendung für eine breite Community an Forschern interessant, da sich einerseits fachspezifische Formeln und Folgeberechnungen durchführen und und per Link teilen ließen, wie es Nutzer von Cloudspeichern gewohnt sind. Wert wurde darauf gelegt möglichst mit Open-Source-basierten Lösungen zu arbeiten, die in Forschung und Lehre frei eingesetzt werden können. Rechenzentren könnten das Webtool dann künftig zentral hosten und für Studierende und Mitarbeiter installations- und kostenfrei nutzbar machen.

Leider wird uns auch der Kollege Dr. Hussein Hussein verlassen Richtung FU Berlin. Interessierte finden Detiails zur Stellenausschreibung hier:

https://www.tu-chemnitz.de/verwaltung/personal/stellen/257090_1_Si.php

Anfang des Jahres erhielt das audiovisuelle Labor der Juniorprofessur Media Computing seinen letzten Schliff. Der Bühnenkäfig ist ausgestattet mit 16 Lautsprechern, 64 Mikrofonen und 10 Stereokameras (Smart Sensors), die eine Vielzahl an Objekten und Geräuschen aufzeichnen und lokalisieren können. Die ermittelten Daten werden von einem “Storage System” mit 64 Terabyte Speicherkapazität gesichert und verarbeitet. Zwei (MIDI-) Keyboards sorgen für die Generierung von Tonsequenzen für unterschiedliche Instrumente, welche in der Erforschung der akustischen Lokalisierung ihren Einsatz finden sollen.

Am 01.02.2017 wurde das Labor in Betrieb genommen und für Forschungen zur Objekt- und akustischen Lokalisierung genutzt. Weiter Informationen finden sich unter technische Ausstattung des MC-Labors und werden auf der International Summer School on Computer science, Computer Engineering and Education Technology in Laubusch vom 03.–07.07.2017 vorgestellt.

Ziel war die Verbesserung der Vorjahres-Ergebnisse unter Nutzung von Open Source Tools auf Consumer Hardware. Dabei sollten vor allem speziell entwickelte Annotationswerkzeuge zur kollaborativen Nutzung über ein Webinterface zum Einsatz kommen mit denen mehr Ground-Truth Daten pro Zeiteinheit erzeugt werden können. Außerdem wurden Zeiten erfasst um u.a. die effizientesten Nutzer für den interaktiven Run zu bestimmen. Daten-Grundlage des Wettbewerbs war auch dieses Mal wieder die britische TV-Serie “Eastenders”. Im Wettbewerb galt es bestimmte Rollen der Serie an einem definierten Ort automatisiert zu ermitteln. Dazu erfolgte im ersten Schritt nach der Extraktion der sog. Keyframes deren Annotation durch Markieren von Personen mit Bounding Boxen (mittels Rechtecken, siehe Abbildung) und Metadatenanreicherung mit Ortsinformationen. Zur Personen- und Ortsklassifikation wurden dann im zweiten Schritt neuronale Netze (CNNs — Convolutional Neural Networks) trainiert. Da aufeinanderfolgende Bilder am selben Ort mit großer Wahrscheinlichkeit zu einer Szene (Shot) gehören, wurden Ähnlichkeitsmetriken angwandt, um Bilder einem Shot und damit einer Gruppennummer zuzuordnen. Schritt drei beinhaltete ein Re-Ranking der Ergebnisse der CNNs durch Mittelung der CNN-Konfidenzwerte aller Bilder einer Gruppe. Schließlich folgte im interaktiven Run die manuelle Evaluation der Ergebnisse mit Hilfe des Webinterfaces durch den zeiteffizientesten Annotator.

Die Forscher erzielten mit ihrer Methode eine durchschnittliche Trefferquote von 31,8% im Interactive Run und 14,4% im Automatic Run, wobei die Top 10 Präzision 90,5% (IR) und 49,7% (AR) betrug. Damit erreichte die TU Chemnitz den 2. Platz im Interactive Run und den 5. Platz im Automatic Run.